17485/J XXVII. GP

Eingelangt am 11.01.2024

Dieser Text wurde elektronisch übermittelt. Abweichungen vom Original sind

möglich.

Anfrage

der Abgeordneten Mario Lindner, Eva-Maria Holzleitner, Katharina Kucharowits,

Genossinnen und Genossen,

an den Bundesminister für Arbeit und Wirtschaft

betreffend „Inakzeptable Stereotypen und Bias bei der neuen AMS-KI“

„Wer Chatbot-Software von der Stange kauft und die Neigung von ChatGPT zu Vorurteilen ignoriert, darf sich nicht wundern, wenn das Ergebnis nicht passt“ – so bezeichnend untertitelte DerStandard.at schon am Tag nach dem Launch des neuen KI-Chatbots des Arbeitsmarktservice die offensichtlichen Probleme mit dieser Anwendung.[1] Von den großmundigen Ankündigungen zum neuen AMS-Berufsinfomat, der Arbeitssuchende durch den Einsatz von künstlicher Intelligenz bei der Jobsuche unterstützen soll, ist in der Realität wenig übrig geblieben. Während sich Nutzer*innen in den sozialen Medien schon wenige Stunden nach der Präsentation der Anwendung über oft sinnbefreite und gerade zu bizarre Antworten des Chatbots amüsierten, zeigten zahlreiche Beispiele schon bald danach die Reproduktion von inakzeptablen Stereotypen und die Wiedergabe von offensichtlichem Bias, also eine Verzerrung anhand von Kriterien wie Gender etc., in der Arbeitsweise der KI auf.

Ganz grundlegend stellt sich die Frage, welche Anforderungen und Zielsetzungen bei der Erstellung der neuen AMS-Anwendung verfolgt wurden. Wie DerStandard.at darlegt, handelt es sich beim Chatbot um eine „Softwarelösung von der Stange“ – diese „wird genau so auch auf der Website der Stadt Basel eingesetzt und soll dort Touristinnen und Touristen zu Sehenswürdigkeiten geleiten und den Weg zum nächsten Restaurant weisen“.[2] Ob die Anforderungen an eine Technologie für Städtetourismus mit jenen für Fälle, in denen beispielsweise junge Menschen sich Gedanken um ihre berufliche Zukunft machen, vergleichbar sind, scheint mehr als fragwürdig. Angesichts der Anschaffungskosten von rund EUR 300.000 steht inzwischen zurecht der Verdacht von Fahrlässigkeit im Raum.

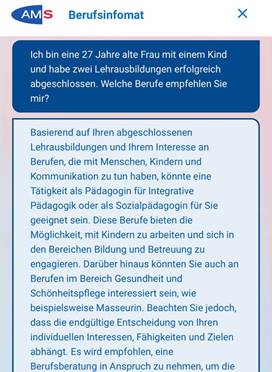

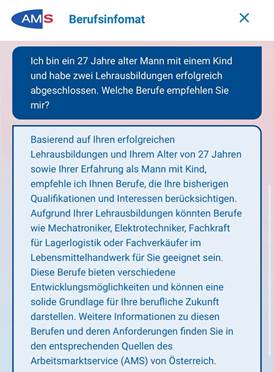

Viel tiefgreifender scheinen jedoch Probleme bei der Weitergabe von Stereotypen bei der Berufswahl. Auch wenn das AMS nach öffentlicher Kritik Adaptierungen ankündigte, bleibt zu bezweifeln, wie wirksam diese sein können. Dass die Reproduktion von Vorurteilen auf unwissenschaftlicher Basis zu einem der Grundprobleme von Anwendungen im Bereich der künstlichen Intelligenz gehört – auch von solchen, die mit deutlich größerem Mittelaufwand betrieben werden – wird seit langem von Forscher*innen, Expert*innen und sogar Betreiber*innen solcher Anwendungen kritisiert. Genau dieses Muster zeigt sich auch beim AMS-Berufsinfomat. Frauen und Männer erhalten dabei mit denselben Voraussetzungen unterschiedliche Antworten, wie die nachfolgenden Beispiele leider deutlich darlegen:

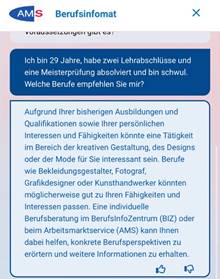

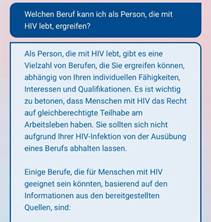

Der offensichtliche Bias der Software zeigt sich aber nicht nur bei den unterschiedlichen Perspektiven, die Männern und Frauen aufgezeigt werden. Auch bei anderen Kriterien, beispielsweise Migrationsgeschichte, Namen oder sexueller Orientierung zeigen zahlreiche Beispiele ganz klare Vorurteile, die für ein öffentliches Arbeitsmarktservice absolut inakzeptabel sind. Warum beispielsweise einem schwulen Mann, ohne nähere Angaben zu Interessen und bisherigen Arbeitsbereichen, automatisch „kreative Berufe“ vorgeschlagen werden, lässt sich schwer begründen. Dasselbe gilt beispielsweise für den Hinweis, dass darauf zu achten ist, dass Arbeitgeber von HIV-positiven Personen „bereit sind, Anpassungen vorzunehmen und eine inklusive Arbeitsumgebung zu schaffen“, was „die Nutzung von assistiver Technologie und barrierefreie Arbeitsplätze umfassen“ kann. Derartige Aussagen sind nicht nur unwissenschaftlich, sondern stehen auch mit bestehenden gesetzlichen Diskriminierungsverboten in Konflikt.

Die unterfertigten Abgeordneten stellen daher folgende

Anfrage:

1. Laut Medienberichten beliefen sich die Gesamtkosten des AMS-Berufsinfomats als Kooperationsprojekt zwischen dem BRZ und der Firma goodguys auf rund EUR 300.000: Wie hoch waren die genauen Gesamtkosten für die Erstellung des AMS-Berufsinfomats und wie genau gliedern sich diese?

2. Wie hoch sind die regelmäßigen Betriebs- und Wartungskosten für den AMS-Berufsinfomat?

3. Welche Abläufe und Vereinbarungen existieren hinsichtlich allfälliger Änderungen, Adaptierungen etc. beim Betrieb des AMS-Berufsinfomat, insbesondere auch hinsichtlich der dafür anfallenden Kosten?

4. Wurden auch Angebote von anderen Anbieter*innen zur Erstellung dieser Anwendung eingeholt und auf welcher konkreten Grundlage kam es zur Entscheidung für das gegenwärtige Modell?

5. Wie genau wird sichergestellt, dass die vom AMS-Berufsinfomat gesammelten und verwerteten Daten nicht an Dritte, insbesondere Unternehmen außerhalb der EU, weitergegeben werden?

6. Welche Trainingsdaten wurden konkret für die Erstellung der KI des AMS-Berufsinfomat verwendet und wie wurden diese ausgewählt?

a. Welche Trainingsdaten wurden auf Basis welcher Kriterien genau ausgewählt?

b. Aus welchen Quellen wurden diese Trainingsdaten gespeist?

c. Wo sind diese Trainingsdaten gespeichert?

7. Welche konkreten Daten wurden insbesondere mit Bezug auf die Arbeitsweise und bisherige Erfahrungen des AMS verwendet?

a. Wie wurde bei AMS-bezogenen Daten sichergestellt, dass keine persönlichen Daten an nicht-legitimierte Dritte weitergegeben wurden bzw. werden?

8. Ist es geplant, der KI des AMS-Berufsinfomat künftig weitere Daten als Trainingsdaten zur Verfügung zu stellen und wenn ja, welche?

9. Welche konkreten Anforderungen, Kriterien etc. wurden seitens des AMS bei der Auftragserteilung zur Erstellung des AMS-Berufsinfomats vorgegeben?

a. Wie genau gestaltete sich in diesem Zusammenhang insbesondere die Einbindung der Abteilung für Gleichstellung im AMS und hatte diese Kontroll- und Feedbackmöglichkeiten?

10. Wie wurde sichergestellt, dass in den Trainingsdaten für die KI des AMS-Berufsinfomats kein Bias, insbesondere hinsichtlich des Geschlechts, enthalten ist?

11. Wie wurde sichergestellt, dass in den Trainingsdaten für die KI des AMS-Berufsinfomats keine unwissenschaftlichen Daten, enthalten sind?

12. Wie wurde sichergestellt, dass der AMS-Berufsinfomat alle in Österreich geltenden Gesetze, insbesondere solche hinsichtlich der Gleichbehandlung und Antidiskriminierung am Arbeitsplatz, weitergibt und in seine Antworten inkludiert?

13. Wie und von wem wurde der AMS-Berufsinfomat vor der Veröffentlichung, insbesondere hinsichtlich eines möglichen Bias getestet und welche konkreten Schlüsse wurden aus dieser Testung gezogen?

14. Welchen konkreten Nutzen erfüllt der AMS-Berufsinfomat, den andere öffentlich zugängliche, textbasierte KI-Anwendungen nicht haben?

15. Zu welchen Adaptierungen ist es seit der Veröffentlichung des AMS-Berufsinfomats gekommen, um möglichen Bias und die Reproduktion von Vorurteilen, beispielsweise hinsichtlich des Geschlechts oder der sexuellen Orientierung, auszuräumen?

a. Zu welchen konkreten Adaptierungen ist es wann beim Prompt der KI-Anwendung gekommen?

16. Welche weiteren Adaptierungen sind in Zukunft beim AMS-Berufsinfomat geplant, um möglichen Bias und die Reproduktion von Vorurteilen, beispielsweise hinsichtlich des Geschlechts oder der sexuellen Orientierung, auszuräumen?

a. Zu welchen konkreten Adaptierungen ist es wann beim Prompt der KI-Anwendung gekommen?